想象一下,某次万众期待的体育巅峰对决刚开场,平台同时涌入百万观众——视频开始卡顿、弹幕延迟、聊天室秒崩,一时间社交平台炸锅,“垃圾平台”登上热搜。

为什么会这样?很多平台在面对突如其来的高并发流量时,架构设计根本扛不住:

架构是单点部署,压力一来直接炸;

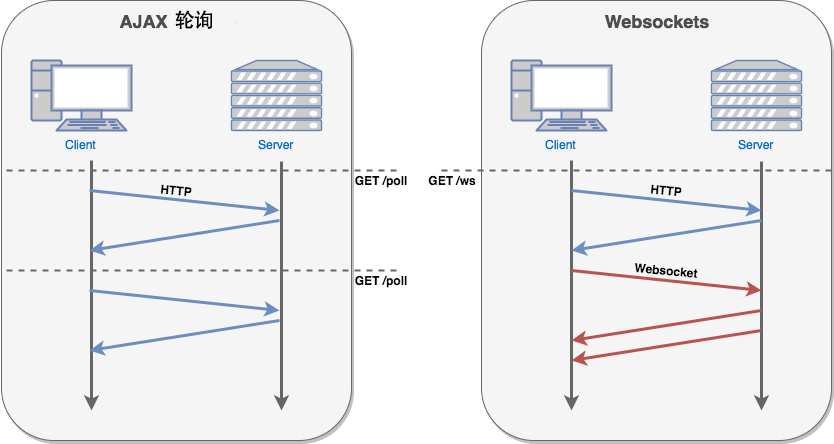

WebSocket连接泛滥没人管理,资源耗尽;

数据库写入争抢严重,堵塞严重;

缺乏降级机制,一个模块挂全线瘫;

带宽和CDN准备不足,视频源断断续续。

这些问题的根源,归结为:没有为高并发量身打造的架构系统。

百万级用户同时在线,体育直播平台所承受的不只是视频推流压力,背后还有消息广播、用户管理、弹幕互动、评论系统、数据写入等多线程并发挑战。

关键难点如下:

连接层压力山大:WebSocket需要长连接,百万用户等于百万持久连接,传统Nginx根本顶不住。

服务耦合度高:评论、弹幕、用户系统绑在一起,任一模块卡顿就连锁反应。

数据库瓶颈突出:弹幕、评论同时写库,瞬时并发写操作容易导致锁争用。

实时性要求高:直播需要“准实时”,延迟一秒,用户可能就关掉了直播间。

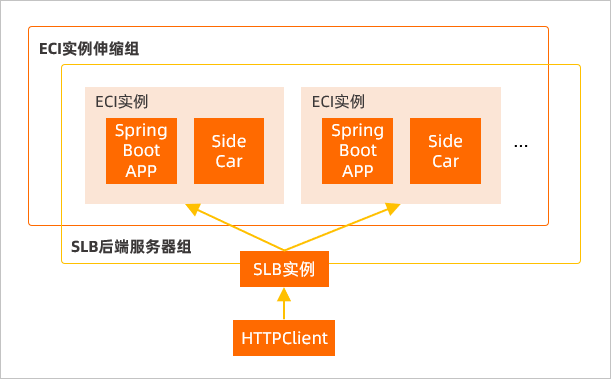

无法动态扩容与监控:没法在高并发到来时实时扩容,架构完全被压垮。

针对这些问题,东莞梦幻网络科技“体育直播系统源码方案”打造了一套弹性、分布式、高可用的系统架构,以下是核心设计:

所有视频流和静态资源走 多地域CDN 加速;

WebSocket接入用 OpenResty + Lua,单机可扛百万连接。

将用户、聊天、推流、积分、商品等拆分为独立服务;

用 gRPC + Nacos + Istio 做服务治理,稳定可靠。

弹幕接入 Kafka 消息队列,不直接写库,削峰填谷;

热门直播间弹幕数据直接走 Redis 缓存,确保不卡顿。

所有连接状态集中存储在 Redis;

心跳检测+超时踢人,避免僵尸连接占用资源;

消息推送用 Redis Pub/Sub,做到精准 + 高速推送。

数据库采用 MySQL 主从 + 分库分表;

热数据缓存入 Redis,采用异步任务写回数据库。

推流支持 RTMP / SRT / HLS 多种协议;

拉流全部走 CDN,用户端根据网速选择码率,自适应不卡顿。

弹幕服务挂了,直播还能照常播放;

用 熔断 + 多机房热备,任何节点挂掉不会影响全局服务。

使用 Prometheus + Grafana 监控系统性能;

与阿里云/腾讯云联动,根据流量自动扩容实例。

打造一个真正“扛得住百万并发”的体育直播平台,绝不是简单堆机器,而是从底层架构设计就要具备弹性、解耦、可监控、可恢复的能力。

推荐:

初创企业:采用云服务 + 分布式微服务模式起步,避免一开始架构死板。

中大型平台:通过服务网格、自动扩容体系增强系统韧性。

有直播需求的项目方:优先部署CDN与推流集群,保证视频流畅。

如果你正在开发或运营一个直播平台,建议对照上述架构逐步优化,特别是弹幕和WebSocket连接部分,往往是最容易卡住用户体验的核心点。

需要完整源码或部署方案?欢迎咨询「东莞梦幻网络科技」,我们有成熟案例和实战经验支持你从0到1打造一个真正“不卡顿”的体育直播平台!